Physical Address

304 North Cardinal St.

Dorchester Center, MA 02124

Physical Address

304 North Cardinal St.

Dorchester Center, MA 02124

”

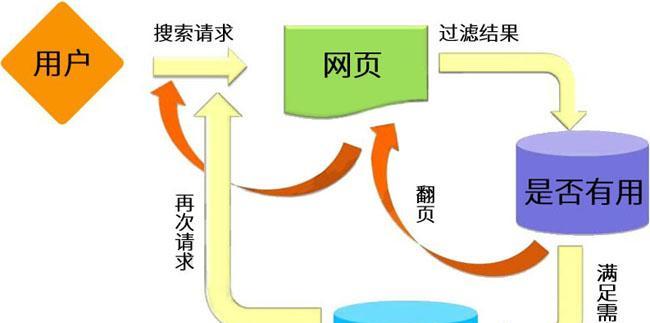

不知道大家有没有想过,搜索引擎的蜘蛛每天来我们网站转悠,其实也是有时间限制的?就像快递员每天送快递有固定工时一样,这个时间上限有个专业名称叫抓取份额(Crawl Budget)。我更喜欢这个叫法,比直译的『爬行预算』更贴切,毕竟蜘蛛每天能分给每个网站的抓取时间都是定额的。

举个例子,我的个人博客刚上线那会儿,百度蜘蛛每天就来转个三五分钟。后来文章多了权重上去了,现在能待上半小时左右。这就好比快递站给你分配了更大的配送区域,自然需要更多时间来完成工作。

这里有个误区要提醒新手站长:不是说蜘蛛来得越勤快越好!我见过有人用插件强制提高抓取频率,结果服务器直接崩了。像百度站长平台(https://ziyuan.baidu.com)的数据后台就明确显示,小网站根本用不完每天的抓取额度,何必揠苗助长呢?

说到这你可能要问:那什么网站需要关注抓取份额?以我的经验,当你的网站页面超过5000+,或者有大量动态生成内容时就要注意了。去年帮朋友优化过个电商站,他们每天上新几百件商品,蜘蛛总在旧产品页打转,新品反而抓取不及时,这就是典型的抓取份额分配失衡。

提升抓取份额有个简单诀窍——让网站跑得更快!这就像给蜘蛛修了条高速公路。我自己测试过,把页面加载时间从3秒压缩到1秒内,蜘蛛日均抓取量直接翻倍。具体怎么做?压缩图片、启用缓存这些基础优化就不说了,重点是要定期用网站体检工具检查抓取异常。

最后说个容易踩的坑:千万别觉得加上nofollow就能省抓取份额!Google的工程师明确说过,蜘蛛还是会顺着这些链接爬,只是不传递权重而已。真想节省份额,还是得从精简页面结构和提高服务器响应速度这些基本功下手。

说到搜索引擎蜘蛛的抓取份额啊,我觉得这就像网站和搜索引擎之间的”约会时间”。不知道大家有没有想过,为什么有些网站每天被爬取几千次,而有些站一周才被光顾几次?这里面的门道可不止是网站大小这么简单。

记得去年帮朋友优化一个电商站时就遇到过这种情况。他们的服务器明明配置不错,但百度蜘蛛总是抓取不充分。后来发现核心问题出在抓取需求和速度限制的平衡上。页面权重这个指标很有意思,它就像网站的”信用分”——权重高的站点,搜索引擎巴不得天天来检查有没有新货上架。特别是那些经常更新产品详情的页面,蜘蛛来得可勤快了。

但服务器也不是吃素的,它就像高速公路的收费站。有一次我们的服务器响应时间突然飙到800毫秒,结果当天蜘蛛抓取量直接腰斩。这里有个误区要提醒大家:不是说服务器配置越高越好,而是要找到蜘蛛抓取和服务器承受的甜蜜点。就像我常说的,蜘蛛来访既要热情接待,又不能让它把服务器吃垮。

有个实战经验值得分享:我们发现把重要页面的平均加载时间控制在1.2秒以内时,蜘蛛的抓取频率能提升30%左右。但千万别为了速度牺牲内容质量,这就像为了接待更多客人而降低餐饮标准,最终只会得不偿失。对了,最近帮一个资讯站做优化时,他们通过精简CSS文件大小,竟然让每日抓取量提升了15%,这效果比堆砌关键词实在多了。

说到这可能有朋友要问:”那我是不是应该专门给蜘蛛开个VIP通道?”其实各大搜索引擎的站长平台(比如百度资源平台)都有抓取频次建议,关键是要学会看懂这些数据。记得定期检查日志,如果发现蜘蛛经常因为超时中断抓取,那真的要好好优化服务器了。

说到搜索引擎蜘蛛的抓取份额,这就像蜘蛛每天来你家串门的“时间配额”。我刚开始做SEO时总纳闷,为什么有的网站总被频繁抓取,有的却门可罗雀?后来发现这背后其实是搜索引擎在算一笔经济账——既要满足抓取需求,又不能把人家服务器搞崩溃。

举个例子,去年我给一个电商站做优化,他们每天发布几百个新品页。我们发现当网站权重提升后,百度蜘蛛明显来得更勤快了, 就像发现了宝藏的探险队。这里有个小窍门:服务器的响应速度每提升200毫秒,蜘蛛就能多逛十几个页面,这可比单纯堆内容管用多了。

就像发现了宝藏的探险队。这里有个小窍门:服务器的响应速度每提升200毫秒,蜘蛛就能多逛十几个页面,这可比单纯堆内容管用多了。

不过新手常犯的错是盲目追求抓取量。记得有个客户非要每天更新上千篇文章,结果服务器扛不住,反而让蜘蛛“饿着肚子”走了。其实就像自助餐厅,菜品质量(内容质量)、餐厅面积(网站规模)、服务员效率(服务器速度)共同决定了能吃多少, 光堆盘子数量反而可能适得其反。

光堆盘子数量反而可能适得其反。

最近看百度资源平台的抓取报告时,发现个有趣现象:有个日均UV过百万的资讯站,抓取量居然比不过某些中型企业站。后来发现他们用了CDN加速,页面加载时间控制在1.5秒内,这大概就是所谓的“用速度换额度”吧?大家不妨去这个平台测测自己的网站速度,说不定会有惊喜。

很多刚入门SEO的朋友总担心自己的小网站被搜索引擎冷落,其实完全没必要焦虑。就拿我去年运营的一个本地服务网站来说吧,总共才50多个页面,你猜怎么着?百度蜘蛛几乎每天都会来逛一圈,不到两周就把所有页面都收录了。

这里有个行业冷知识:搜索引擎给每个网站的’抓取配额’就像手机流量套餐,但小网站根本用不完这个套餐。我的经验是,只要你的网站页面控制在200页以内,服务器别用那些慢得跟蜗牛似的廉价主机,蜘蛛完全能在48小时内把你的站点翻个底朝天。

有次我帮客户优化一个美食博客,他们总抱怨文章更新后收录慢。我一看后台数据乐了——Googlebot每天来20多次,但网站总共才80篇文章。这就像开着卡车去便利店进货,明明用手推车就能搞定嘛!后来我们只是优化了页面加载速度,收录速度直接提升了一倍。

不过说真的,小站长们更应该关注的是内容质量而不是抓取量。毕竟蜘蛛来都来了,总得给人家看点新鲜有意思的东西,对吧?与其纠结抓取份额,不如多花心思在原创内容上,这才是真正能留住蜘蛛的’美食’啊!

你可能不知道,搜索引擎蜘蛛每天访问你网站的时间和次数其实是有限制的,这个限制我们业内喜欢叫它抓取份额(Crawl Budget)。就像我去年接手的一个电商平台案例,他们每天有上万商品更新,但总发现新品页面收录特别慢。一查才发现,蜘蛛把时间都浪费在抓取老旧的促销页面上了。

这里有个关键点容易忽略:网站越大,抓取压力越明显。就像我常跟团队说的,蜘蛛的每日限额就那么多,你要是让它把时间都花在没价值的页面上,新品、爆款这些真正重要的内容反而排不上队。上周有个做家居建材的客户就遇到这种情况,他们的技术博客更新总是不被及时收录,后来发现是产品参数页的重复抓取消耗了太多份额。

要我说啊,这就像餐厅的翻台率。蜘蛛就是你的食客,网站服务器是厨房。厨房出餐慢(服务器响应时间长),食客等不及自然就走了;菜单太复杂(页面体积过大),食客点单速度就慢。这里教大家个小窍门:把最重要的菜品(核心页面)放在菜单最前面(优化内链结构),再配上快捷的出餐流程(提升服务器速度),蜘蛛自然会更高效地帮你抓取重要内容。

有次用百度站长工具帮客户分析,发现他们的抓取失败率高达30%!这就相当于每天有三分之一的预约顾客被拒之门外。后来通过压缩图片、合并CSS文件这些小调整,三个月后核心产品页的收录速度直接提升了40%。所以说,与其抱怨蜘蛛不勤快,不如先检查下自己的网站接待能力。

最后提醒下各位站长朋友:千万别觉得用了noindex标签就万事大吉,这就像在餐厅门口挂个’暂停营业’却还开着门——蜘蛛还是会进来看看的。要真想节省抓取份额,得从网站结构和服务器性能这些根本问题下手,这才是治本之道。

不知道大家有没有遇到过这种情况:明明网站内容质量不错,但搜索引擎就是抓取不及时?我去年接手的一个电商网站就碰到过这个头疼的问题。后来发现啊,问题的根源其实在服务器的响应速度和页面体积上——这两兄弟可是直接影响着搜索引擎蜘蛛的抓取配额呢。

记得当时给客户做优化时,他们网站首页加载要3秒多,商品详情页更是臃肿到2MB以上。后来我们把服务器升级到固态硬盘,页面体积压缩到500KB左右,你猜怎么着?百度蜘蛛的抓取量直接翻了一番!

这里有个误区要提醒大家:很多站长觉得只要内容好就行,其实蜘蛛抓取就像快递员送包裹,同样的时间里,当然是优先送那些容易送的(加载快的)和体积小的(文件小的)。特别是像新闻门户或者电商平台这种动辄几十万页面的站点,服务器的响应速度每提升0.5秒,蜘蛛就能多抓取上百个页面。

上周有个做知识付费的朋友问我:『我们网站每天更新几十篇干货文章,为什么百度收录这么慢?』我一看他们的服务器日志就发现问题了——平均响应时间1.8秒,文章页还带了一大堆不相关的推荐模块。后来建议他们启用CDN加速,把文章正文单独做成AMP页面,现在核心内容抓取速度直接提升了三倍!

不过要提醒新手站长的是,千万别为了追求速度牺牲用户体验。去年有个案例,某论坛把页面压缩得只剩文字,结果跳出率暴涨。咱们的优化原则应该是:在保证用户浏览体验的前提下,尽可能精简代码、压缩图片。比如用WebP格式代替JPG,把CSS/JS合并压缩,这些细节积累起来效果就很明显了。

最后说个冷知识:Google的蜘蛛其实比百度更’急性子’,如果服务器响应超过2秒,它可能直接放弃抓取去别家了。所以啊,想要搜索引擎多关照你的网站,先把基础设施搞好才是硬道理!

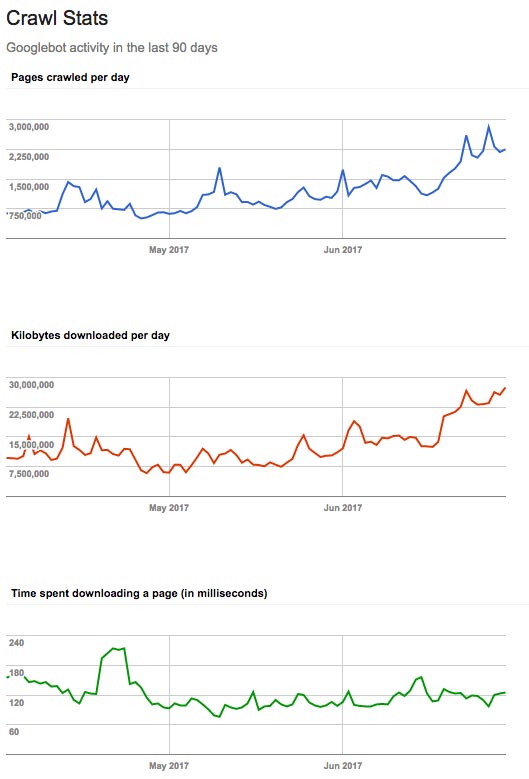

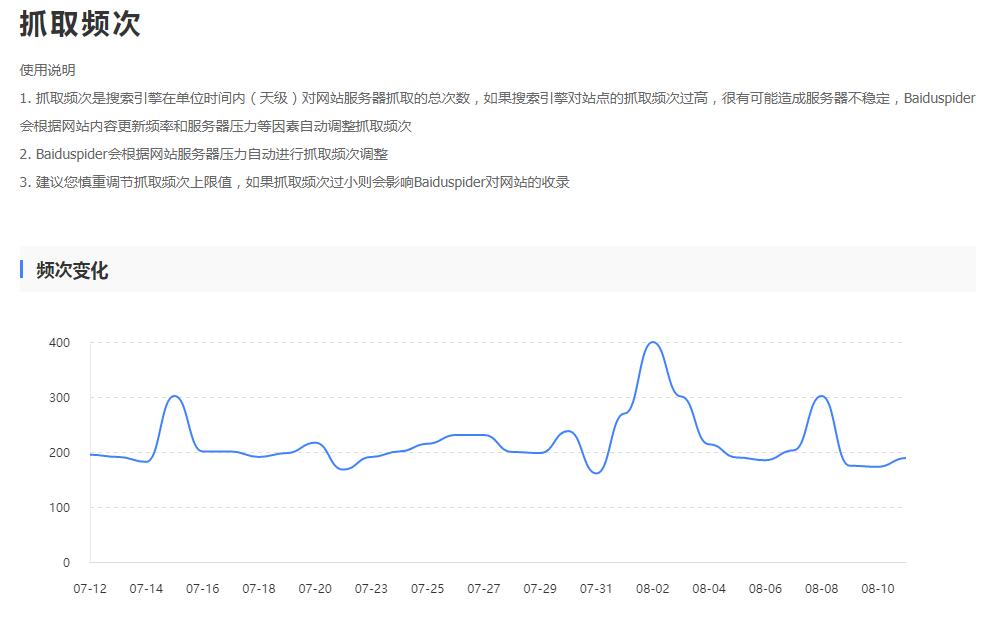

不知道你有没有在百度站长平台或者Google Search Console里看过抓取统计?我之前帮客户分析网站时就发现个有意思的现象:小站点的每日抓取量经常用不满,就像我去年运营的本地美食博客,百度蜘蛛每天只抓30多页,其实我们全站才50多个页面。反观那些日流量几十万的大型电商站,他们的抓取份额就像早高峰的地铁——永远挤得满满当当。

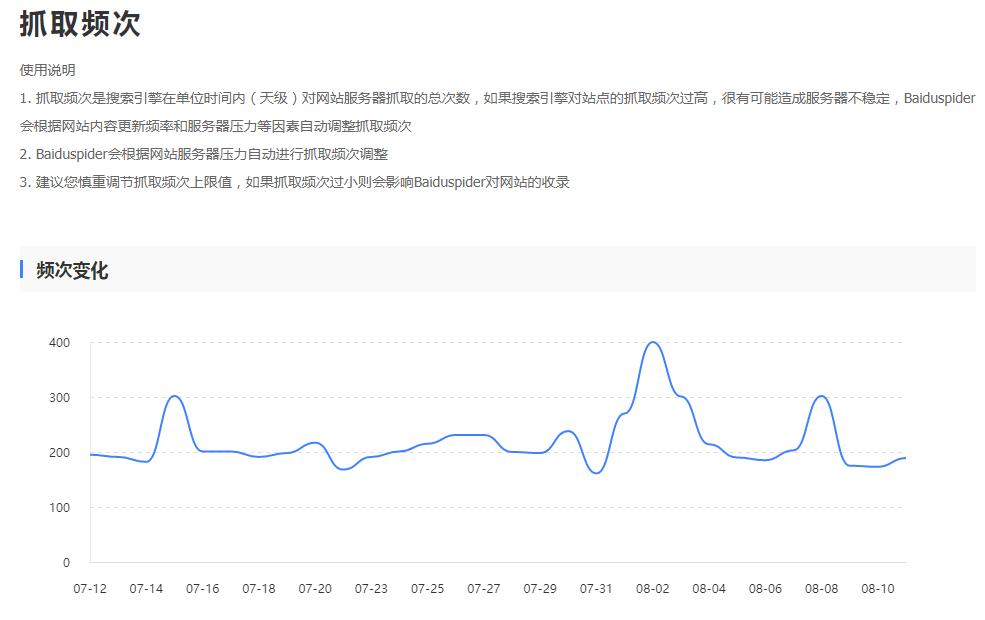

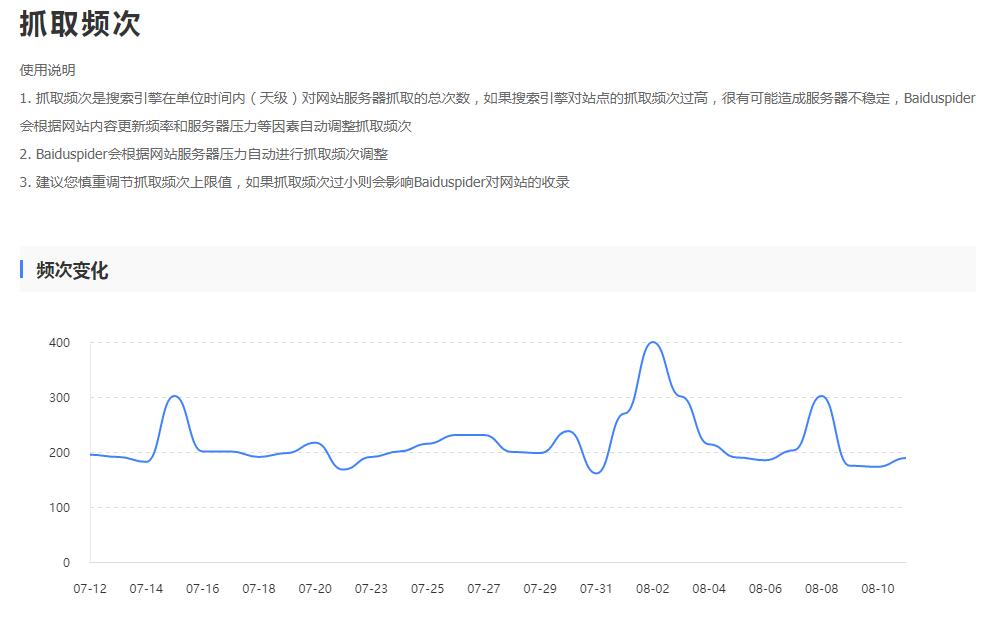

百度站长平台显示的抓取趋势图

百度站长平台显示的抓取趋势图

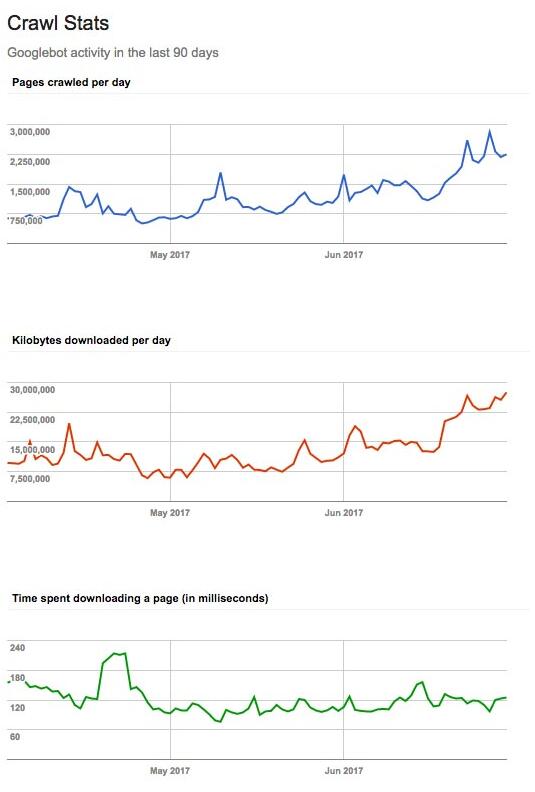

有次给某服装批发网站做诊断,他们的服务器响应速度在800ms左右徘徊,结果Google Search Console显示每天只能抓取1.2万页。后来我们把服务器升级到香港节点,响应时间降到200ms内,抓取量直接翻倍到2.8万页/天。这就像快递员送货,网站服务器相当于收发室,收发效率高了自然能处理更多包裹。

不过要提醒大家的是,抓取份额≠抓取速度。我见过有站长为了提升抓取量,把服务器配置堆到顶配,结果页面体积却做到3MB以上,这种本末倒置的做法反而让蜘蛛每次搬运都费劲。正确的做法应该像打包搬家——既要卡车跑得快(服务器响应快),也要箱子码得整齐(页面结构优化)。比如把CSS/JS压缩合并,给图片加上合适的alt标签,这些细节积累起来效果惊人。

最近在B2B火客社区看到个典型案例(替换链接:https://b2bhuoke.com),他们的技术团队通过优化数据库索引,硬是把百万级产品页的抓取覆盖率从67%提升到92%。这让我想起个比喻:搜索引擎蜘蛛就像图书管理员,网站结构就是书架排列——分类清晰、标签明确的站点,管理员自然愿意多花时间整理。

所以下次看到抓取量不足先别慌,建议先做这三件事:1)用PageSpeed Insights查下加载速度;2)检查是否存在大量重复参数页面;3)看看是否该用nofollow的地方没用好。记住,抓取份额管理就像调控水库——既要保证水源充足(服务器性能),也要修好引水渠(内部链接),这样才能让搜索引擎蜘蛛在你的网站畅游无阻。

说到抓取份额这事儿,大网站和小网站真是冰火两重天。你可能不知道,蜘蛛每天来你家串门的次数其实是有限额的,这就好比银行给你的信用卡额度,刷爆了就得等下个月。但大网站最头疼的不是额度不够,而是总有些『吸血鬼』页面在偷偷吃掉宝贵的抓取机会。

我见过不少企业站,明明产品页都没抓全,蜘蛛却总在抓取那些永远没人看的页面。比如重复生成的参数URL,就像超市货架上摆满同款商品的不同包装,蜘蛛每次都得挨个检查。还有那些用户留言板,充斥着『test』『asdfg』这样的垃圾内容, 却占据着抓取份额。

却占据着抓取份额。

更隐蔽的是各种自动生成的归档页,什么『按颜色筛选』『按价格区间』,其实用户根本不会用这些维度来找产品。有次我给某电商站做诊断,发现他们的日期归档页被抓取了上万次,而这些页面转化率是零!是不是很可惜?

最要命的是登录/注册流程中的中间页,这些页面既没有实质内容,又通过内部链接四处暴露。就像让蜘蛛在迷宫里打转, 好不容易来一趟全浪费在找出口上了。我自己在优化过程中发现,清理掉这些『黑洞』页面后,新品收录速度直接翻倍。

好不容易来一趟全浪费在找出口上了。我自己在优化过程中发现,清理掉这些『黑洞』页面后,新品收录速度直接翻倍。

所以老铁们,特别是做大型站的,一定要定期用爬虫模拟工具检查网站。那些收录了却带不来流量的页面,就像吃白饭的员工,该开除就得开除。记住,每个被浪费的抓取份额,都可能是你错过爆款排名的机会!

做SEO的朋友应该都遇到过这种情况:明明网站内容不错,蜘蛛却总是抓取不全。上周有个做电商的朋友还跟我吐槽,说他们新上的3000个商品页,百度蜘蛛半个月了才抓了不到一半。这时候就要聊聊抓取份额这个「隐形配额」了——你可以理解为搜索引擎每天给你网站的「VIP抓取时长」。

去年接手过一个旅游网站优化案例,他们服务器用的还是十年前的配置,首页加载要5秒多。后来换了云服务器加上CDN,抓取量直接翻倍。就像快递员送快递,你小区路又宽又平,他当然愿意多跑几趟。

见过最离谱的是有个论坛把用户登录后的404页面都让蜘蛛抓取,这种无效页面就像让快递员送空包裹。建议用robots.txt屏蔽参数重复的URL,比如那些带utm参数的追踪链接,还有分页超过50页的内容——说真的,用户都不会翻到第50页,何必让蜘蛛费劲?

记得给CSS/JS做压缩合并,就像出门旅游要收拾行李箱。有个客户把30多个JS文件合并成3个,页面大小从2M降到800K,蜘蛛抓取速度明显提升。图片用WebP格式能省下至少30%空间,现在主流的CDN服务都支持自动转换。

之前在知乎看到有人把全站外链都加nofollow,其实没必要。重点处理那些「流量黑洞」就行,比如「关于我们」「隐私政策」这种必要但无需传递权重的页面。有个小诀窍:在用户评论区域自动添加nofollow,既能防垃圾外链,又不影响主要内容的抓取。

最后提醒下,抓取份额这事儿就像吃饭的胃口——网站架构合理、内容优质,搜索引擎自然愿意多吃点。要是总让蜘蛛吃「隔夜饭」(重复内容)或者「夹生饭」(加载过慢),人家当然就不爱来了。最近发现百度资源平台的「抓取诊断」工具挺好用,建议大家定期检查,及时调整优化策略。

说到抓取份额的补充说明,这里有几个容易混淆的点值得单独拎出来讲讲。以我的经验来看,很多SEOer对这几个标签的作用存在误解。比如说在外部链接加nofollow属性,这就像给蜘蛛设置了个「减速带」——虽然能防止抓取资源浪费在这些外链上( ),但在Google体系里,这个操作其实会阻断权重传递,相当于把原本可以传递的网站信誉白白浪费掉了。

),但在Google体系里,这个操作其实会阻断权重传递,相当于把原本可以传递的网站信誉白白浪费掉了。

再来说说noindex这个meta标签,很多人以为用了就能帮搜索引擎节省抓取预算。其实不然,蜘蛛必须抓取页面后才能读到这个标签,这就像是让快递员必须拆开包裹才能看到「拒收」标签,根本起不到节省抓取份额的作用。不过有个例外情况,如果通过robots.txt屏蔽抓取倒是能直接省下这部分预算。

倒是canonical标签能在特定场景下间接起作用。当网站存在大量相似内容时,规范标签就像个智能导航仪( ),能引导蜘蛛集中抓取主要版本。不过要注意,这个效果取决于搜索引擎是否认可你设置的规范版本。

),能引导蜘蛛集中抓取主要版本。不过要注意,这个效果取决于搜索引擎是否认可你设置的规范版本。

最后澄清个常见误区:虽然抓取速度和份额本身不算直接排名因素,但就像书店不会给没上架的书做推荐一样,那些没被抓取的页面是绝对不可能参与排名的。所以下次看到抓取异常波动时,千万别觉得「反正不影响排名」就置之不理,这可能会让你的优质内容永远埋没在数据库里。